마지막 업데이트 이후 있었던 변화에 대해 업데이트를 하려 한다.

1. Arista DCS-7060CX-32S

기존 Mellanox SX6012가 RoCE v2 구성을 위한 일부 기능 및 명령어 미지원, 일부 NIC와의 Negotiation 호환 문제로 스위치 교체를 고려 하고 있었는데, 마침 Arista 제품이 매물로 나온 것을 보게 되어 구매 하게 되었다.

Arista Networks DCS-7060CX-32S

32개의 100G QSFP28 인터페이스와 2개의 10G SFP+ 인터페이스가 있는 제품이다.

Arista Networks의 장비를 다뤄보고 싶었고, 기존 NIC가 100G를 지원하는데 스위치의 한계로 40G를 쓰고 있었어서 기변 욕구를 참고 있었는데 운 좋게 매물이 나온 것을 보자마자 바로 구매.

이로서 기존 100G NIC의 속도를 맞출 수 있게 되었고, 무엇보다 해당 기종을 활용한 RoCE v2 레퍼런스가 많았기에 더 유리하게 되었다.

명령어도 기존 SX6012보다 더 유연하고, 많은 기능을 지원 하여서 설정하기가 편했다. (ECN 지원, switch forwarding-mode의 선택 가능 등)

감성비는 덤.

이제 내 환경에도 100G의 시대가!

2. Dell PowerEdge R640, Supermicro SYS-6019U-TN4R4T

vSAN을 사용 해보기 위해 ESXi Host로 사용 할 추가 서버가 필요 하였다.

단, 이번에는 U.2 NVMe 슬롯이 제공 되는 것을 조건으로 걸고 이에 부합한 서버를 구매 하였다.

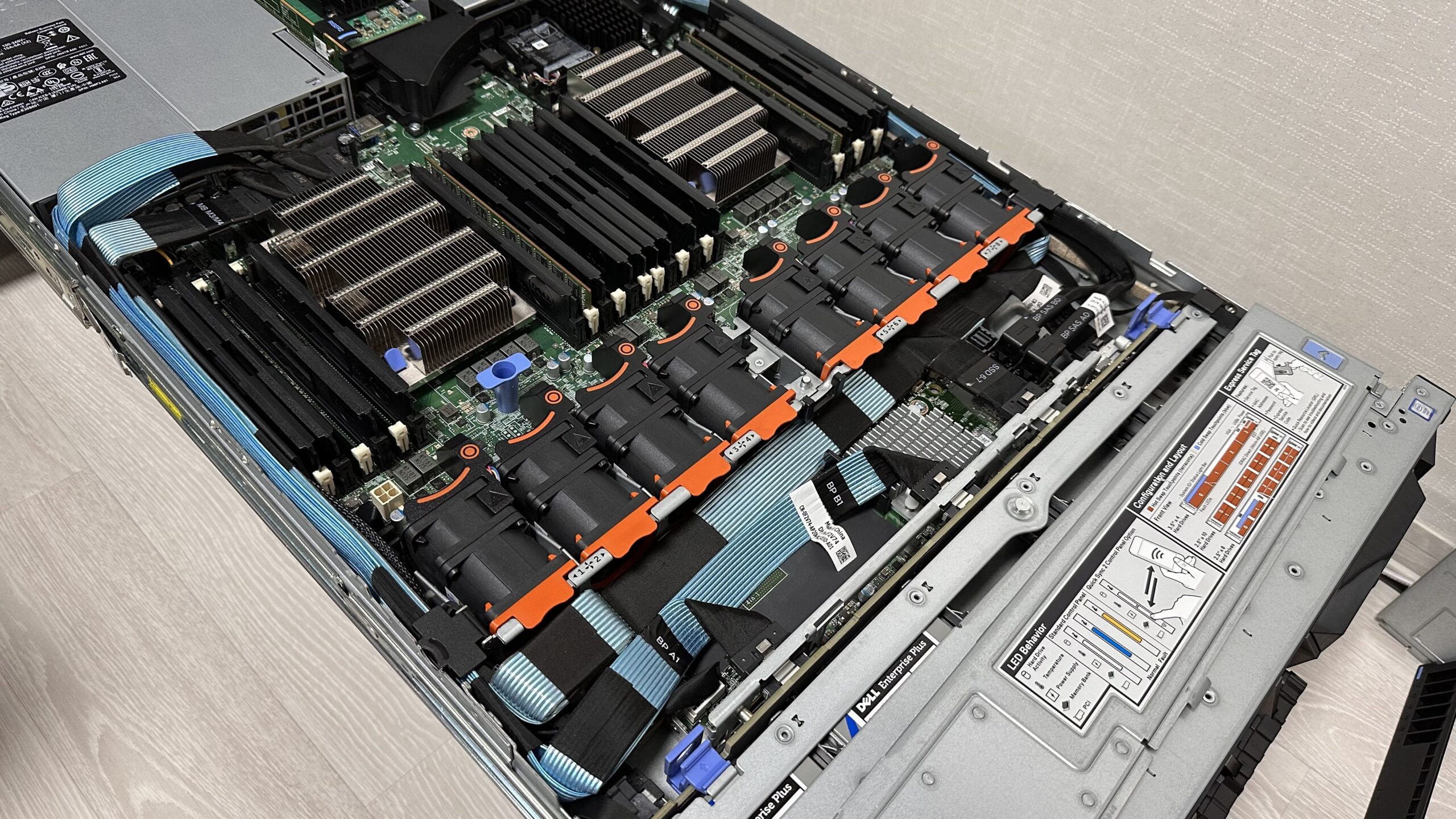

먼저 Dell의 PowerEdge R640 10 SFF 모델이다.

해당 모델은 공식적으로 최대 12개(전면 10 SFF, 후면 2 SFF)의 U.2 NVMe 슬롯을 지원하는데, 내가 구매 한 모델은 전면 10 SFF 모델이다.

구매 하였을 때는, 해당 모델 출고 당시 NVMe 관련이 없던 모델 이여서 메인보드의 PCIe MCIO 포트와, 백플레인의 PCIe MCIO 포트를 연결해주는 케이블이 하나도 장착되어 있지 않았다.

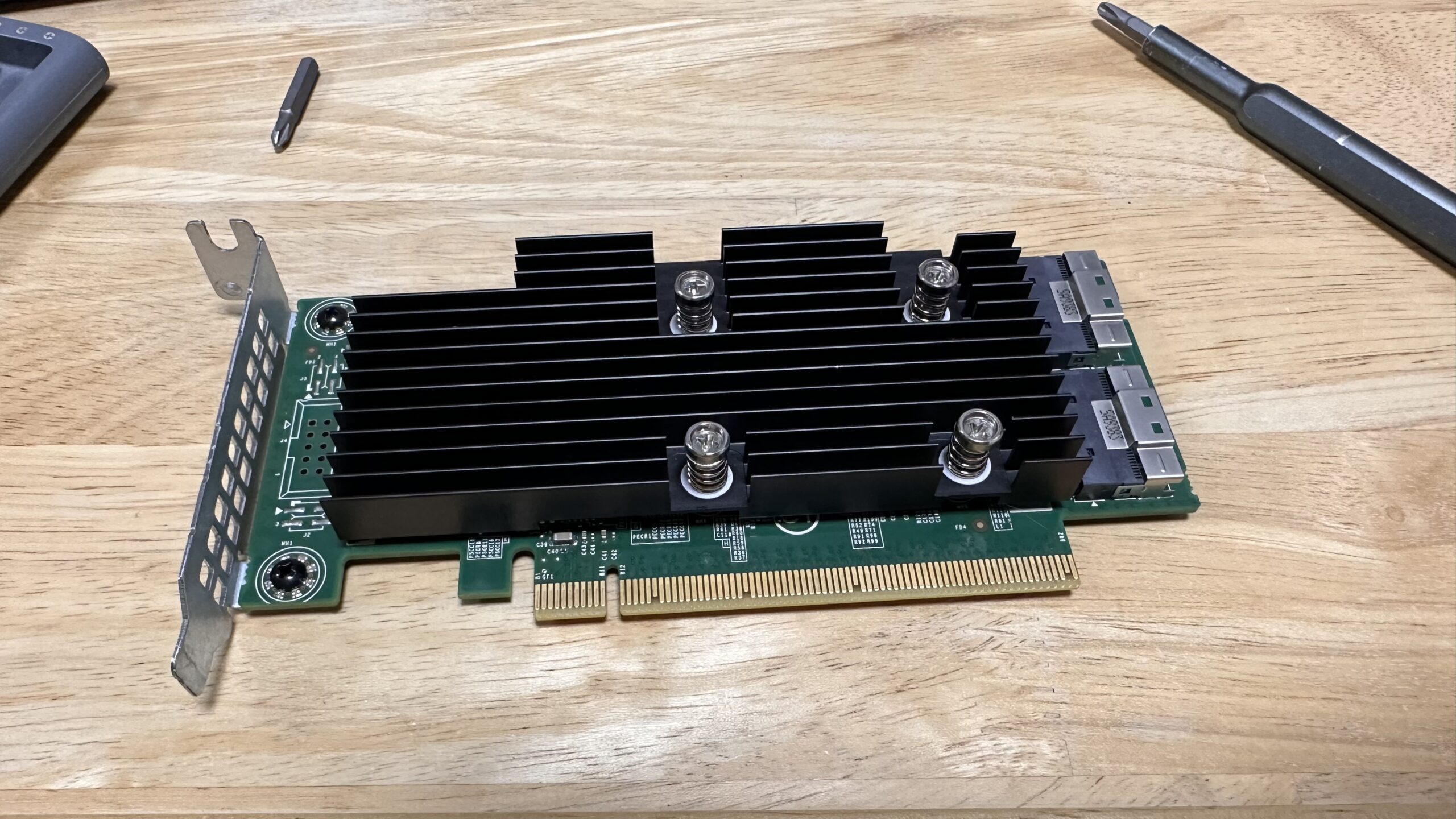

나는 U.2 NVMe를 사용 할 예정이라, 누락된 MCIO 케이블 및 PCIe Expander 를 eBay에서 별도로 구해서 장착 하였다.

다음으로는, 이 글의 가장 위에 있던 사진 내 푸른 빛을 내고 있던 서버인 Supermicro의 SYS-6019U-TN4R4T 모델이다.

해당 모델은 전면 베이 구성은 4 LFF이나, 백플레인이 NVMe를 함께 지원한다.

즉, SATA/SAS/NVMe 를 전부 지원한다!

운 좋게도 백플레인과 메인보드의 PCIe Slimsas 커넥터 까지 전부 구성 되어 있던 모델이라 별도 파츠를 추가 구매 하지 않았다.

다만, 한 가지 문제가 있었는데 해당 모델이 사실 순정 모델이 아니라 IBM SOFTLAYER OEM 모델이였다.

BIOS를 업데이트 하려했는데, Secure Flash를 지원하지 않는 BIOS 이미지라고 오류를 뱉어서 보니… OEM모델을 적용 하면서 BIOS도 자체 정책에 맞게 인증 서명을 적용 한 것이다.

이렇게 되면 BIOS이미지에 올바른 서명내용이 없으면 업데이트를 할 수 없다.

그냥 사용을 할까 했는데, BIOS내 IPMI 설정 탭이 없고 PCIe 관련 설정도 가려져 있는 것을 확인 했다.

이 시점에서 OEM BIOS 이미지가 도대체 어디까지 손을 대 놨는지 판단을 하기 어려워 졌고, 향후 BIOS 업데이트도 불가능 한 상태라 결국 생애 최초로 EEPROM 프로그래머를 사용 하게 되었다.

현재는 EEPROM 프로그래머를 이용해 강제로 순정 BIOS 이미지를 프로그래밍 해 둔 상태다.

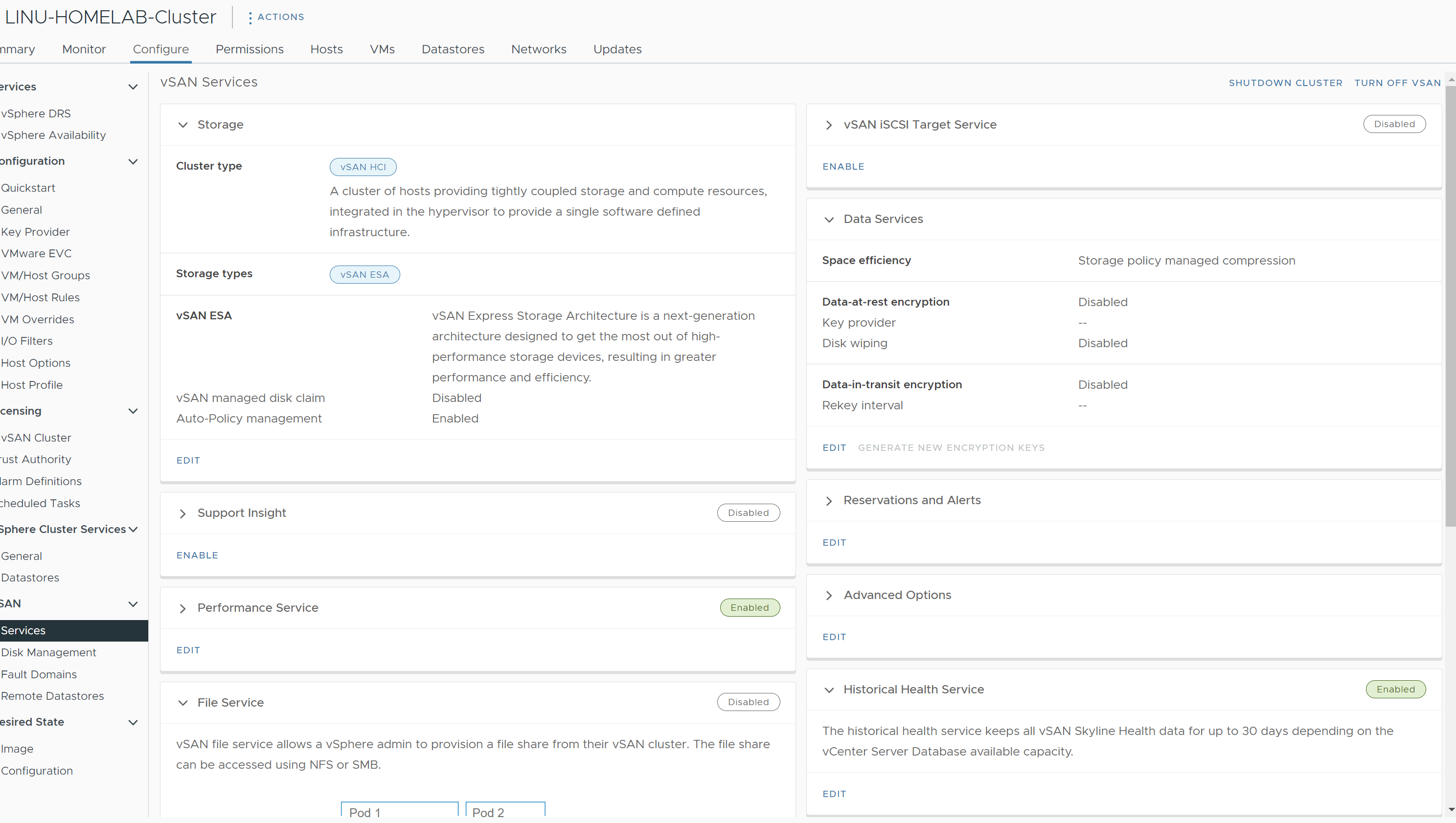

3. VMware vSAN ESA

상기 100G 스위치 도입, 서버 증설 외 추가 U.2 NVMe 디스크 구매, RAM 증설 후 vSAN ESA를 구성 하였다.

vSAN ESA는 vSphere 8.0 출시와 함께 추가 되었던 주요 요소이다.

vSAN ESA는 고성능의 NVMe 디스크 환경에 최적화 된 새로운 아키텍쳐다.

NVMe 디스크를 OSA에서 구성 하는 것 보다, ESA에서 디스크를 구성 하면 OSA보다 더 빠른 성능 과 더 효율적으로 사용 할 수 있게 된다.

보다 자세한 설명은 VMware blog로 대체한다. (Comparing the Original Storage Architecture to the vSAN 8 Express Storage Architecture)

3개 호스트로 구성 하였으며, 현재 클러스터 내 호스트 별 사양은 아래와 같이 구성되어 있다.

- Host 01

– CPU: Xeon Scalable Gold 6138 x 2ea

– MEM: 256GB (64GB LRDIMM x 4ea)

– DISK: Micron 7300 MAX 3.2T x 3ea

– NIC 1 (for vSAN): Mellanox ConnectX-4 100GbE Single Port (MCX455A-ECAT)

– NIC 2 (for VM Net): Mellanox ConnectX-4 LX 25GbE Dual Port (Dell rNDC, DP/N 0R887V) - Host 02

– CPU: Xeon Scalable Silver 4114 x 2ea

– MEM: 256GB (32GB RDIMM x 8ea)

– DISK: Micron 7300 PRO 3.84T x 4ea

– NIC 1 (for vSAN): Mellanox ConnectX-4 100GbE Single Port (MCX455A-ECAT)

– NIC 2 (for VM Net): Mellanox ConnectX-4 LX 25GbE Dual Port (Dell rNDC, DP/N 0R887V) - Host 03

– CPU: Xeon Scalable Silver 4114 x 2ea

– MEM: 256GB (32GB RDIMM x 8ea)

– DISK: Micron 7300 PRO 3.84T x 4ea

– NIC 1 (for vSAN): Mellanox ConnectX-4 100GbE Single Port (MCX455A-ECAT)

– NIC 2 (for VM Net): Mellanox ConnectX-4 LX 25GbE Dual Port (MCX4121A-XCAT -> MCX4121A-ACAT로 Crossflash)

vSAN Storage Policy는 RAID-5(Erasure Coding), FTT=1, Compression only를 적용 하였다.

추가로 해당 클러스터는 RDMA를 사용 하도록 기능을 활성화 하였고, 스위치에도 적절한 설정을 진행 하였다. (DCBx, QoS, PFC, ECN 등…)

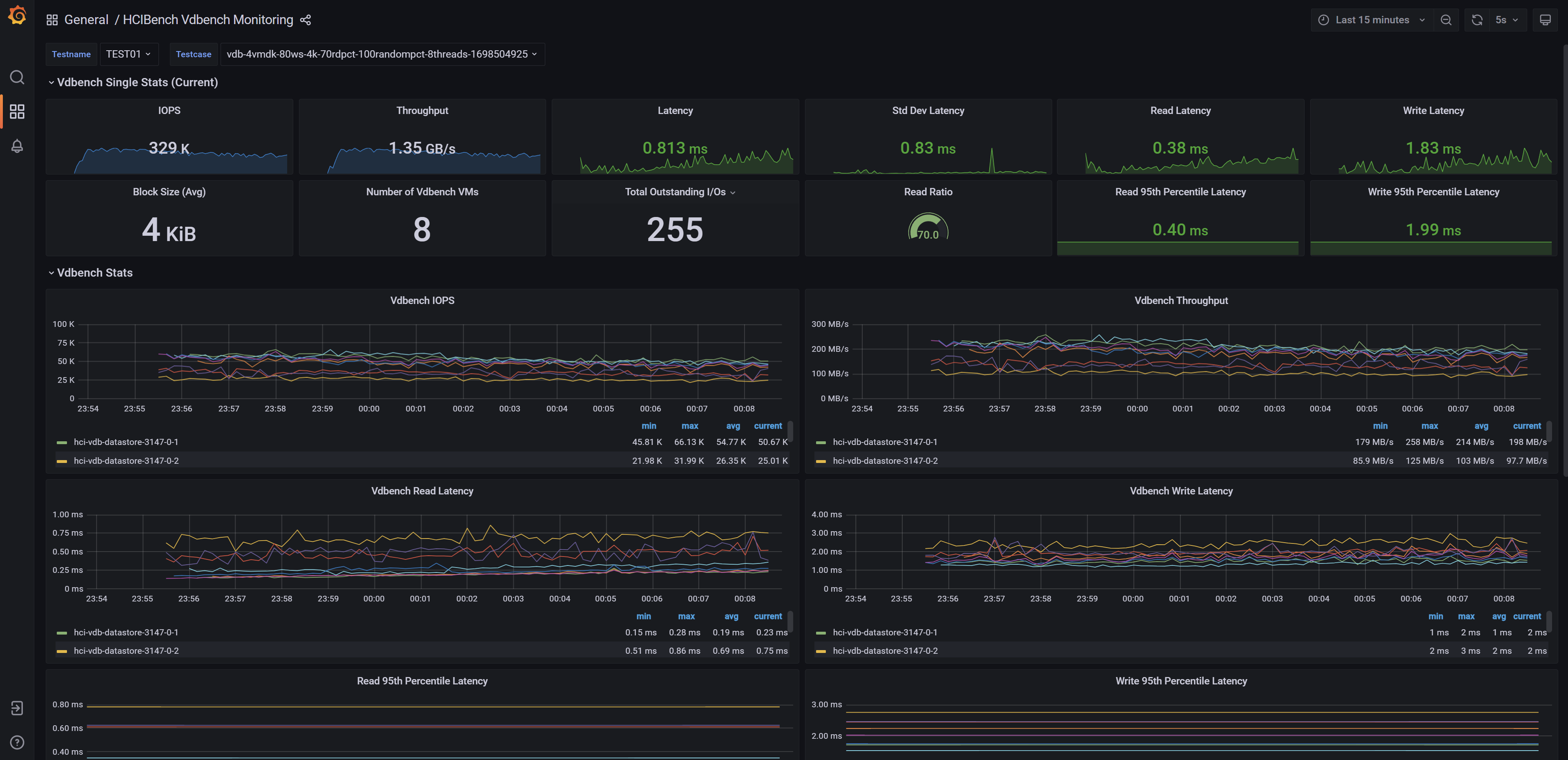

vSAN ESA를 구성 하고 간략하게 HCIBench를 진행 해 보았다.

Workload 설정은 아래와 같이 진행.

– Block size: 4KiB

– VM: 8ea

– VMDK: VM당 4

– I/O Threads: 8

– Working Set: 80%

– 70% Read, 30% Write

– 100% Ramdom I/O

결과는 대만족.

NVMe 디스크지만 분산 스토리지 시스템에, RAID-5, Compression 상황에서 4KiB 블록 처리가 초당 처리량이 1GB/s를 넘는 것을 보고 충격을 감출 수가 없었다.

Latency도 크게 뒤쳐 지지 않고 안정적으로 작동 하는 모습을 확인 하였다.

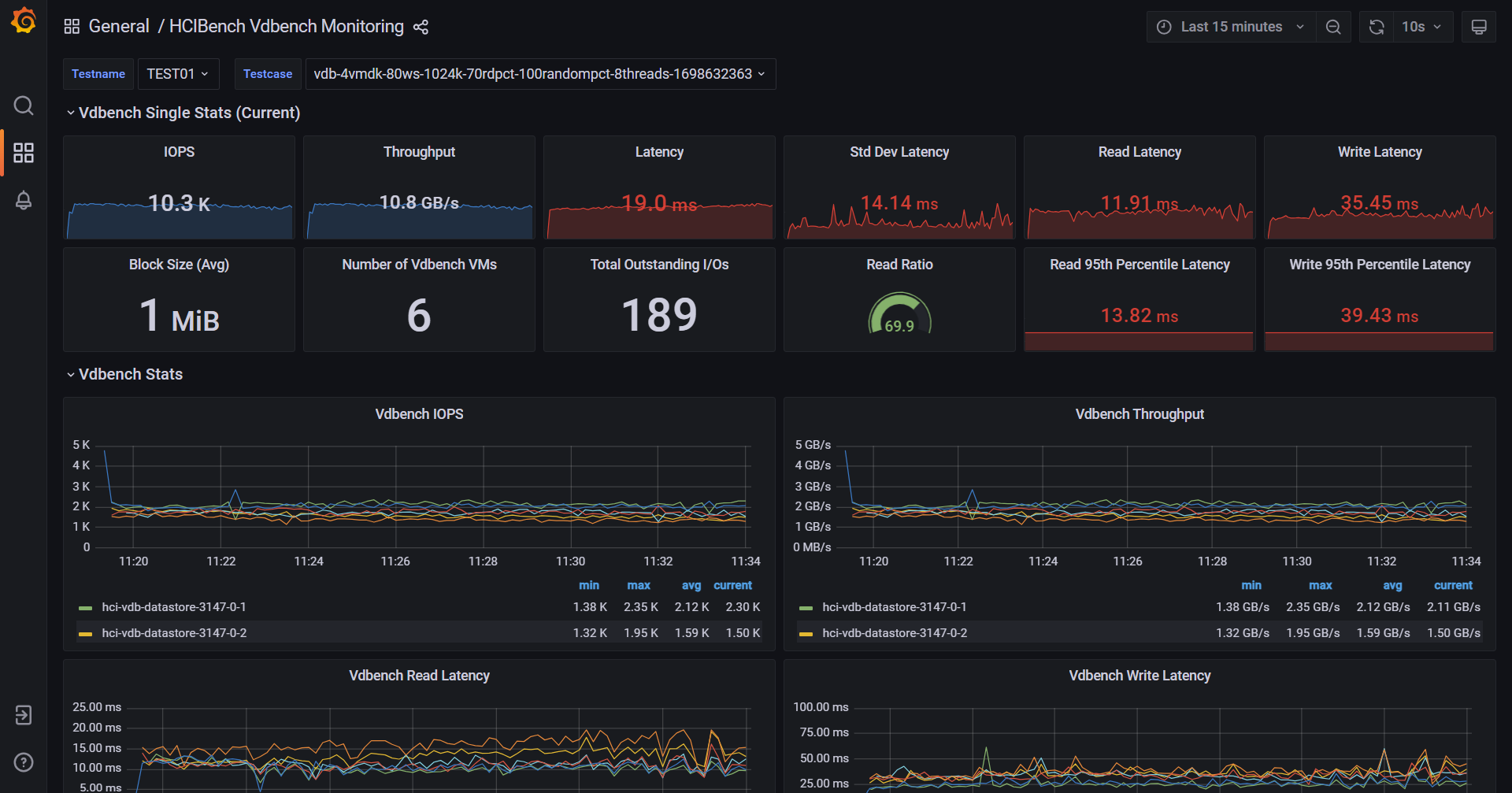

3-1. VMware vSAN ESA 번외 – 1MiB Test

번외로 상기 조건에서 VM은 6ea, Block Size는 1MiB로 변경하여 테스트를 진행 했다.

현재 클러스터의 사양 및 네트워크의 한계를 알아보기 위함이다.

처음에는 VM수를 8ea로 진행 했는데 CPU 자원이 오버되는 바람에, 클러스터 전체가 불안정하여 중단하고 6ea로 하향 조정 했다.

정리

지난 공백 동안, NW 스위치 업그레이드, 서버 증설, vSAN ESA를 적용 하면서 보다 많은 정보와 기술들을 접하고 익힐 수 있는 기회를 가지게 되었다.

특히, Arista 스위치의 및 vSAN ESA를 직접 운용 해봄으로서 실제 필드에서 활용 할 수 있는 지식과, 데이터가 많이 생겨 유익한 시간 이였다.

Lab 환경의 수준이 올라가며 보다 많은 구성을 시도 해볼 수 있게 되었고, 향후에도 무언가 테스트를 진행 할 때 사양이나, 수량으로 인한 한계로부터 보다 자유로울 것으로 예상 한다.

기존에 사용하시던 6012는 어디서 구하셨던건가요? 요새 구해보려고 찾던중인데 잘 안보이긴하네요. roce말고도 nvmeof 통신방식도 충분히 고려가능한 상황이 아닌가 싶기도 하네용

기존 SX6012의 경우 한대는 국내에서, 한대는 직구로 구매 했었습니다.

NVMe of 의 경우 제 지식부족의 문제와 기타 이슈가 있어서 도전을 못했습니다.

기회가 되면 해보고 싶은데 지금 상태에서 들어내기가 좀 쉽지 않네요 ^^;